Oppsummering av året 2025 for dataplattform

Stian Bakke, seniorkonsulent og gründer av Fraktal

Det har vært nok et år tilsynelatende dominert av nyheter om AI; Hvor mye bedre modellene har blitt. Investeringene som gjøres. Agenter. Arbeidsplasser og mye mer. For noen år siden så ble det spådd sivilisasjonens undergang slik vi kjenner den og en kunne kjenne på at låten «in the year 2525» plutselig hadde innhentet oss på svært kort tid.

I år har diskusjonen om en «AI-boble» blitt sparket i gang og kjente profiler i alt fra investormiljøer til mer tekniske miljøer har tatt til orde for at vi er i en. Uansett er det utrolig hva disse modellene nå klarer gitt hvor vi var for kun få år siden.

På siden, eventuelt i tillegg, skjer det svært mye på områder rundt data som en kan snappe opp og utlede en retning fra. Hvor er vi på vei? Jeg, Stian Bakke, har forsøkt å oppsummere året.

Åpne filformater – Iceberg

Åpne filformater gir oss større valgfrihet, både med tanke på innlåsing men også kostnadsoptimalisering. Det er ikke uvanlig å bruke ulike motorer (eksempelvis Snowflake og Fabric) til ulike ting. For å slippe data-duplisering så hjelper disse formatene oss.

Alle de store skyplattformene for data har nå innebygget støtte for Iceberg. Google BigQuery, Snowflake, Databricks, AWS Athena og Microsoft Fabric tilbyr, eller er i ferd med å tilby, førsteklasses Iceberg-integrasjon. På Open Source siden så har DuckDB også fått full skrivestøtte for Iceberg for ikke lenge siden, og PostgreSQL tilbyr dette gjennom utvidelser.

Iceberg er nå mer eller mindre standarden en samles rundt og en kan undre seg over hva som kommer til å skje med hovedkonkurrenten Delta Tables som Databricks slo seg opp på og som Microsoft baserte Fabric på.

At kampen er helt over er ikke sikkert. Initiativer som DuckLake og filformatet Vortex tyder på at flere mener det etablerte er for komplisert og tregt. Her jobbes det iherdig med selve grunnsteinene rundt moderne databehandling, og sammen med utviklingen av maskinvare så er det all grunn til å tro at kombinasjonen tar oss til nye høyder når det gjelder kapabiliteter.

Infrastruktur, oppetid og sikkerhet

De siste månedene så har det vært flere tilfeller av utfall blant de store globale infrastruktur leverandørene. Et par av de største er Amazon AWS sin us-east1 hendelse. Cloudflare har hatt et par runder med «bugs» som tok ned betydelige deler av internasjonal infrastruktur. Selv om disse selskapene er gigantiske og trafikken de håndterer er enorm så skal det ikke mer enn litt «rusk» til for å ta ned alt. Det er et tankekors.

Det er et stadig økende fokus på sikkerhet og sårbarhet. Om dette er på grunn av et urolig globalt politisk klima eller sårbarhet og angrepskraft gjennom AI er usikkert. Den lange trenden er å gå fra å beskytte mot angrep fra utsiden til å anta at angriperen allerede er på innsiden. Såkalt «Zero Trust».

I Fraktal så jobber vi iherdig med disse temaene. Vi kan ikke være best på data om vi ikke også er best på å sikre de mot uvedkommende. Slurv og manglende forståelse er i hovedsak det som utfordrer på området og vi jobber tett med mange av våre kunder for å heve standarden.

Truls Fretland, fagansvarlig for Maskinlæring

dbt – Økt adopsjon og innebygging

Snowflake og Databricks tilbyr nå innebygget dbt-integrasjon, noe som gjør at en kan kjøre dbt-prosjekter direkte i disse plattformene uten ekstern infrastruktur. Microsoft har lansert det samme for Fabric. En slik form for adopsjon og standardisering kan undertegnede ikke huske, selv med 25 år i bransjen.

dbt har utviklet seg voldsomt de siste årene og i Fraktal så jobber ca. halvparten av våre ansatte med dette i ulike varianter. Semantiske Modeller, Kontrakter, Mesh og andre utvidelser i dbt sørger for at en kan definere flere tidligere svake punkter som en del av kodebasen. «Single Source of Truth» er krevende, både teknisk og organisatorisk, og dbt har vært et kvantesprang for å lykkes med det i praksis.

Som en liten digresjon fra dbt, som startet ut på toppen av PostgreSQL : Snowflake og Databricks har kjøpt hver sine selskaper bygget på denne database-motoren, noe som tyder på at egenskaper i og rundt PostgreSQL-økosystemet begynner å bli svært kraftig og synlig på markedet. Vi ser at for mange så kan PostgreSQL være et ypperlig valg, en kan få både streaming, analyse og vektor-funksjonalitet for AI helt innebygget. De bruker selvsagt mindre penger på markedsføring, så en må lete litt for å finne ut av akkurat det.

Selv om dbt oppsto som open source så har suksessen kanskje først og fremst materialisert seg gjennom dbt Labs sin dbt Cloud, og for litt siden så ble det annsonsert fusjon med Fivetran. Dette har skapt økt nervøsitet og begrepet «dbt Fear Index» har oppstått. Hva skjer om fellesskapet som har vært med å løfte dbt mister innflytelsen og kommersialiseringen tar over? Heldigvis er dbt Core fremdeles open source, det finnes flere alternativer og andre løsninger er under oppseiling. dbt har ført til en varig endring i måten en tenker dataplattform på og det er vanskelig å se at en kommer til å gå mye bakover fra disse prinsippene.

DuckDB: Enkelt og kraftig

DuckDB har blitt stadig mer populært gjennom året og er nå på 25 millioner nedlastinger i måneden. I tillegg begynner den å dukke opp som «standard» i flere data-verktøy. SaaS-varianten Motherduck landet også nylig i Europa. Det blir spennende å følge hvordan adopsjonen blir på kontinentet vårt.

– Langtidsstøtte (LTS)

Med versjon 1.4.0 introduserte DuckDB Long-Term Support (LTS)-utgaver, hvor hver annen versjon får ett års støtte fra fellesskapet. Dette tyder på at DuckDB i økende grad blir brukt i produksjonsmiljøer. I Fraktal så har vi flere kunder som har tatt dette i daglig bruk i sin data-verdikjede.

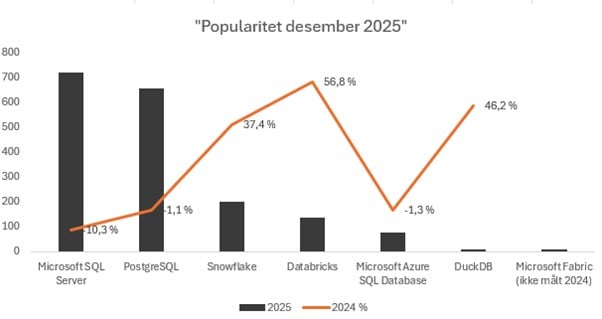

Tall fra : DB-Engines Ranking

Global statistikk på plattformer vi i Fraktal jobber mest med: